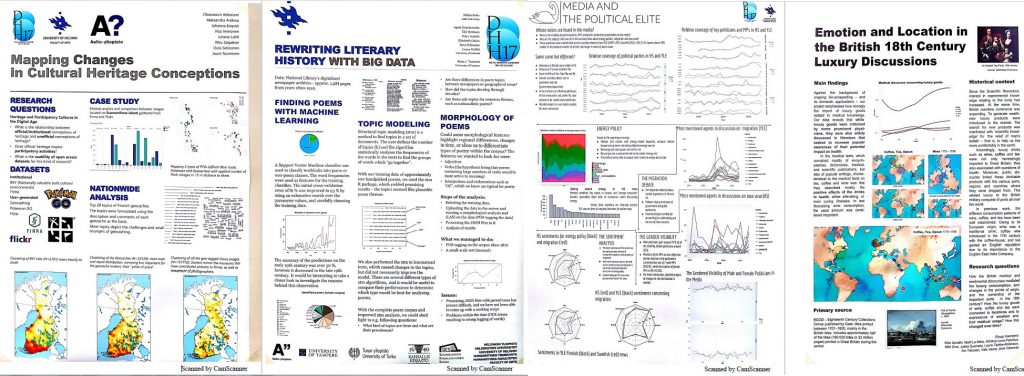

Helsingin yliopiston kirjaston datatuki-työryhmä järjesti DMPTuuli-työpajan 19.6.2017 Helsingissä, Kaisa-talossa. Tavoitteena oli hackathon-maisesti pohtia erityisesti historian tutkijoiden näkökulmasta kuinka yleisesti hankesuunnitelmissa tarvittu aineistonhallintasuunnitelma tehdään ja voisiko näistä eri tapauksista luoda jonkinlaisen ‘arkkityypin’, josta uusia suunnitelmia tekevät voisivat hyötyä omia suunnitelmia tehdessään.

Alussa kävimme läpi hieman taustaa ja motivaatiota aineistohallintasuunnitelmille ja mitä rahoittajat ja arkistointikäytännöt vaativat. Viitattiin myös Suomen Akatemian ohjeistuksiin aineistonhallintasuunnitelmasta joista löysyy myös tarkennukset, mutta kannattaa tarkistaa onko omalla rahoittajalla tarkempia ohjeistuksia.

Dataa, pulmia, ratkaisuja

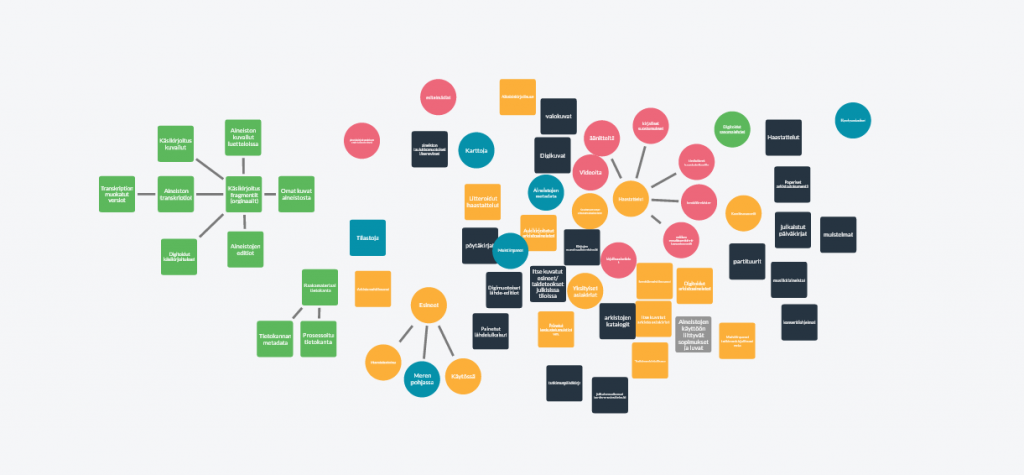

Osallistujat olivat monenlaisista tutkimusaiheista, joten aineistojen kanssa oli erilaisia käytännön pähkinöitä pohdittavaksi joissa ongelmat vaihtelivat eettisistä aina teknisiin. Miten mainita aineiston käyttöluvat, jos niitä ei olekaan kirjallisina? Missä kaikkialla aineistoja voisi säilyttää ja mitkä hyödyt ja riskit eri paikoissa on? Esimerkkinä kerrottiin mm. tietojenkäsittelytieteen puolella esitetty esimerkki, kun koodi on jo jaettu ja ns. “kasvamassa” eri palveluissa tai vaikka linux-jakeluissa, niin tarvitseeko samaa koodia enää pitkäaikaissäilyttää , kun evoluutio on hoitanut jo sen joka puolelle? Lisäksi pohdittiin työryhmissä eri tiedonhallintapaikkojen hyviä ja huonoja puolia, kenen käyttöehtoihin luotat ja miten itse voisi ennaltaehkäistä katastrofia aineistojen käytettävyyden suhteen.

Sisältö <> työkalu

Työryhmäosiossa keskusteltiin aineistonhallintasuunnitelmaan liittyviä kysymyksiä auki , kukin katsoen asiaa oman tutkimuksensa tai -aineistonsa näkökulmasta. Vaikka osa teki tätä DMP Tuuli työkalussa, niin työkalu sinänsä vaikutti suoraviivaiselta. Pulma on kuinka vastata aineistohallintakysymyksiin, joita työkalu tutkijan eteen laittaa. Kaikki kysymykset on oleellisia ja tavoite niissä on hyvä. Ytimessähän on varmistaa, että seuraavakin aineistoa käyttävä pääsee kärrylle siitä mistä aineistossa on kyse. Tutkimusdata pitäisi nähdä arvokkaana resurssina, jota voidaan käyttää myös myöhemmin, joten siitä huolehtiminen on merkittävä osa tutkimusprosessia useimmilla aloilla. Kun käytännöt jo ovat hyvät, aineistohallintasuunnitelma antaa mahdollisuuden kirjoittaa ne talteen ja toisaalta jos vasta on aloittamassa tutkimusprosessia, niin sitten aineistonhallintasuunnitelman voi nähdä ohjeistavan oikealle polulle jo alusta lähtien. DMPTuuli-työkalu näyttää sekä suomalaisia että Helsingin yliopiston omia aineistonhallintaohjeita ja ajatuksia herättäviä kysymyksiä, vakiovastauksia ei ole annettu. Jossa toki puolensa ja puolensa – aineistoja on niin monia eri tyyppejä, joten yksi tapa ei käy kaikille ja saman tutkimusprosessin hankkeen aikana voi päästä käsittelemään useitakin erilaisia aineistotyyppejä.

Rohkeasti siis aineistohallintasuunnitelmia tekemään. Datatukiverkosto auttaa ja aina voi jutella kollegan kanssa, jos jokin aiheuttaa pulmia. Suunnitelman tulee olla mietitty omaan tilanteeseen sopivaksi, mutta aivan pikkutarkalle tasolle ei tarvitse mennä, kun kuitenkin ohjeispituus on noin 1-2 sivua, mikä on kuitenkin josuhteellisen paljon hakesuunnitelmien rajatusta sivumäärästä. DMPTuuli työkalu näyttäisi olevan hyvä apuväline, joten sen kysymysten avulla pääsee alkuun ja jos johonkin kysymykseen ei helpolla tulekaan vastausta, niin ainakin on aihe selvillä, joka tarvitsee selvittää.

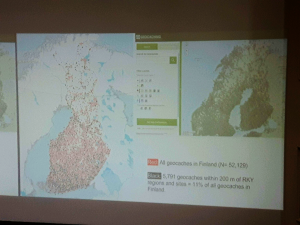

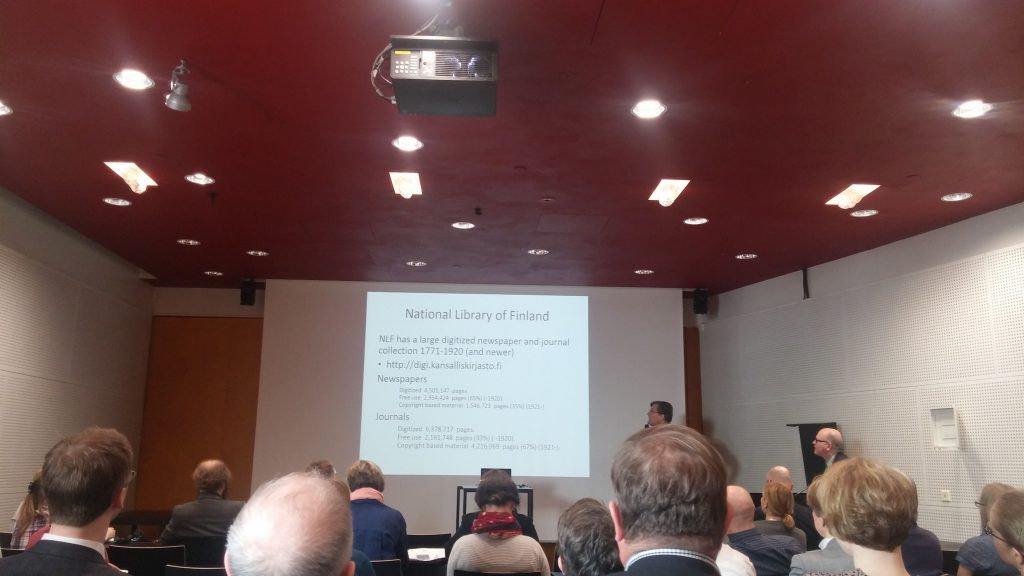

Itse jäin pohtimaan voisiko digi.kansalliskirjasto.fi -palvelun puolella luoda lisää mahdollisuuksia tutkijoille ja listata muutamia keinoja joilla sekä viitata, että käyttää aineistoihin, mutta asia vaatii vielä suunnittelua. Kommentoi alle, jos heti keksit jotakin, jota digiin voisimme kehittää.

Aika ja paikka: ma 28.8. ja ma 4.9. klo 10-12 (Kaisa-talo, Fabianinkatu 30, 5.krs, atk-luokka 5057). (Tilaisuus ei vaadi ilmoittautumista.)

Lisäksi keskustakampuksella järjestetään alkusyksystä kaikille tieteenaloille yhteisiä työpajoja, joihin teidän on toki myös mahdollista osallistua. Alla näiden kaikille yhteisten tiedot – ja huom. näihin tulee ilmoittautua e-lomakkeen kautta.

P.S. Lisää työpajasta Mildred-projektin blogissa.

P.P.S. Syksyllä järjestetään lisää työpajoja, joten tiedoksi historian tai muiden lähialueiden tutkijoille:

DMPTuuli workshops, City centre campus

Place: IT class (5057; 5th floor) of the Helsinki University Main Library in Kaisa building (Fabianinkatu 30).

The location of the class can be checked here:

http://www.helsinki.fi/kirjasto/files/1614/5502/4087/paakirjasto_kerroskartat2016_eng.pdf

Thu, 24 August 2017 at 10-12 am

Tue, 29 August 2017 at 12-2 pm

Wed, 6 September 2017 at 2-4 pm

Thu, 14 September 2017 at 10-12 am

Mon, 18 September 2017 at 12-2 pm

Wed, 20 September 2017 at 2-4 pm

Enrollments by 18 August 2017: