OECD julkaisi toukokuun lopulla tekoälykehitystyölle viisi periaatetta, joita sitä kehittäessä tulisi pitää lähtökohtina. Pidemmässä taustadokumentissa on myös avattu sanastoa ja annettu lisäselityksiä periaatteiden takana.

AI system: An AI system is a machine-based system that can, for a given set of human-defined objectives, make predictions, recommendations, or decisions influencing real or virtual environments. AI systems are designed to operate with varying levels of autonomy.([2], p. 7)

Alkuperäinen ja vapaamuotoinen käännös löytyvät ao. taulukosta.

| AI should benefit people and the planet by driving inclusive growth, sustainable development and well-being. | Tekoälyn tulisi tuoda ihmisille ja planeetoille hyötyä, kannustamalla mukaanottavaan kasvuun, kestävään kehitykseen ja hyvinvointiin. |

| AI systems should be designed in a way that respects the rule of law, human rights, democratic values and diversity, and they should include appropriate safeguards – for example, enabling human intervention where necessary – to ensure a fair and just society. | Tekoälyjärestelmät tulisi suunnitella tavalla, joka kunnioittaa lain sääntöjä, ihmisoikeuksia, demokraattisia arvoja ja monimuotoisuutta, ja niiden pitäisi sisällyttää sopivat turvat – esimerkiksi ihmisen väliintulon tarvittaessa – mahdollistamaan rehellisen ja oikeudenmukaisen yhteiskunnan. |

| There should be transparency and responsible disclosure around AI systems to ensure that people understand AI-based outcomes and can challenge them. | Tekoälyjärjestelmien tulisi olla läpinäkyvia ja vastuullinen ilmoittaminen niistä, jotta ihmiset ymmärtävät tekoälypohjaiset lopputulokset ja voivat haastaa ne. |

| AI systems must function in a robust, secure and safe way throughout their life cycles and potential risks should be continually assessed and managed. | Tekoälyjärjestelmien täytyy toimia vakaalla, tietoturvallisella ja turvallisella tavalla koko elämänkaarensa ajan ja mahdollisia riskejä tulisi koko ajan arvioida ja hallita. |

| Organisations and individuals developing, deploying or operating AI systems should be held accountable for their proper functioning in line with the above principles. | Organisaatioiden ja yksilöiden jotka kehittävät, julkaisevat tai käyttävät tekoälyjärjestelmiä tulisi pitää vastuullisena siitä, että ne toimivat kunnollisesti ylläolevien periaatteiden mukaan. |

Kiintoisaa nähdä, alkavatko nämä periaatteet nousta käyttöön. Kuitenkin jo 42 maata on omaksunut periaatteet ja asiantuntijaryhmä , joka määritelmät on luonut, on kerätty osallistujia eri puolilta.

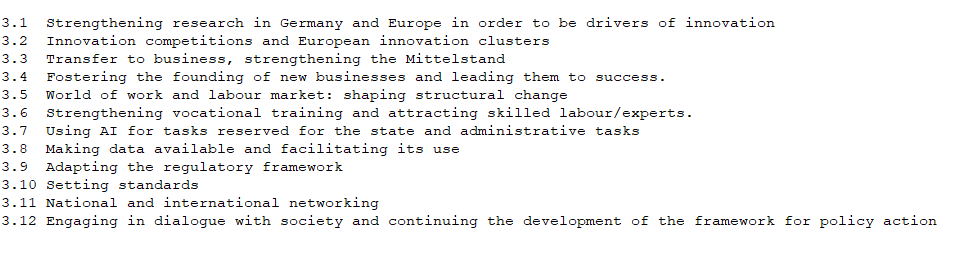

Saksan tekoälystrategian 12 toimenpidealuetta

Saksan tekoälystrategia

Saksan tekoälystrategiassa liikutaan toimenpiteiden ja tavoitteiden välimaastossa. Vuoden 2018 lopussa tehdyssä strategiassa mainitaan 12 tavoitetta, jolla tekoälyn käyttöä valtiossa ja muuallakin yhteiskunnassa pyritään kasvattamaan.

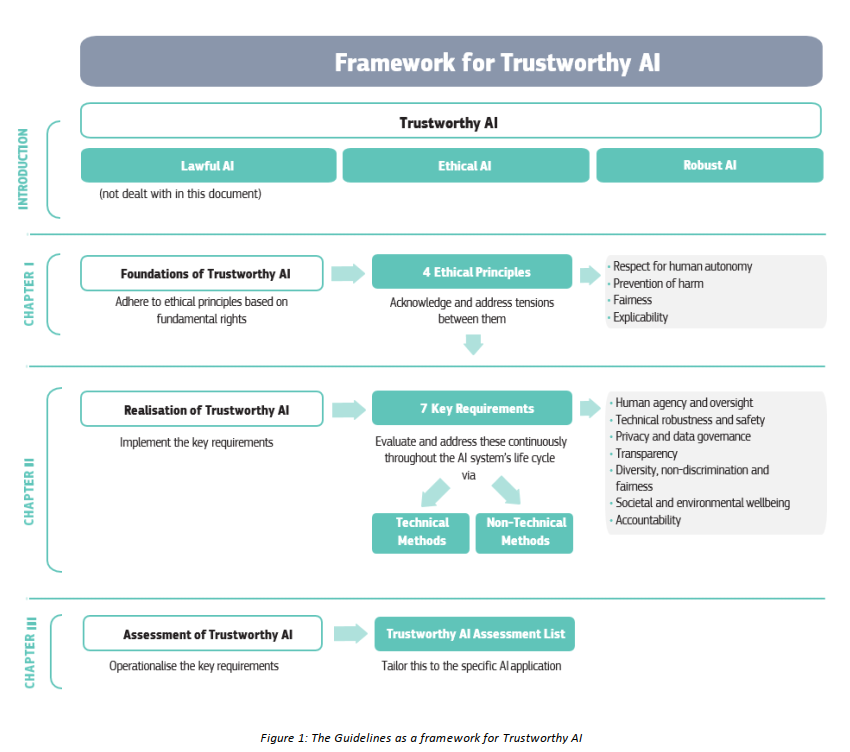

Euroopassa

Euroopassa julkaistiin huhtikuussa 2019 ‘Ethics guidelines for trustworthy AI’ , jossa luotiin kehys, jonka puitteissa tekoälyä eri puolilla yhteiskuntaa tulisi kehittää, kuvattuna am. kuvassa [4].

Suomessa

Suomessa kansallinen tekoälyohjelma tunnetaan AuroraAI-nimellä jonka toimeenpanosuunnitelma pohjautuu ‘Tekoälyaika Suomessa’-raporttiin ja työryhmätyöhön jossa eri osioita on käsitelty laajemmin.

Antti Rinteen tuoreessa hallitusohjelmassa mainitaan tekoäly kahdeksan kertaa.

“Varmistetaan, ettei tekoälyjärjestelmissä hyödynnetä välittömästi tai välillisesti syrjiviä toimintamalleja.”

Joka tuntuisi olevan hyvin linjassa aiemmin esitettyjen tekoälyn periaatteiden kanssa.

Lähteet

[1] OECD. (2019b). OECD Principles on Artificial Intelligence. Osoitteessa http://www.oecd.org/going-digital/ai/principles/